一、引言

一、引言

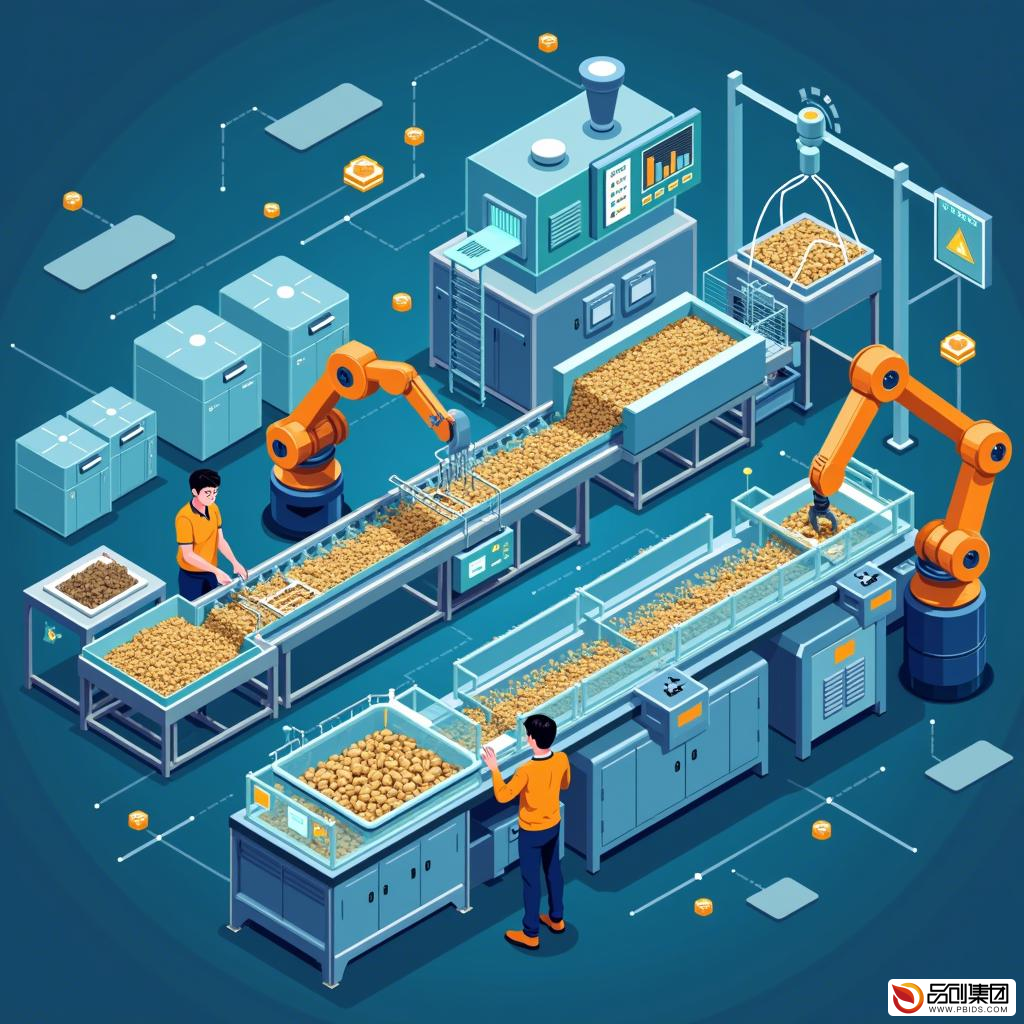

在数据驱动的时代,ETL(Extract, Transform, Load)程序开发成为了数据处理领域的重要一环。ETL程序负责从各种数据源中提取数据,经过清洗、转换和加载,最终将数据整合到目标系统中,为数据分析和决策提供有力支持。本文将深入探讨ETL程序开发的核心概念、工具选择、开发流程以及最佳实践,帮助读者构建高效、可靠的数据流程。

二、ETL程序开发的核心概念

ETL程序开发的核心在于数据的提取、转换和加载。提取(Extract)是指从各种数据源(如数据库、文件、API等)中获取数据;转换(Transform)是指对提取的数据进行清洗、转换和格式化,以满足目标系统的要求;加载(Load)是指将转换后的数据加载到目标系统中,供后续的数据分析和决策使用。

三、ETL程序开发的工具选择

在ETL程序开发过程中,选择合适的工具至关重要。目前市场上主流的ETL工具有FineDatalink、Informatica PowerCenter、Talend、Apache Nifi、Pentaho、Microsoft SQL Server Integration Services (SSIS)等。这些工具在数据提取、转换和加载过程中具有不同的功能和优点,适用于不同的场景和需求。

- FineDatalink

FineDatalink是帆软旗下的一款高效ETL工具,具有高效的数据处理能力、用户友好的界面和与其他帆软产品无缝集成的优势。FineDatalink提供了丰富的数据源支持,包括数据库、文件、API等,能够满足各种复杂的数据处理需求。其独特的数据清洗和转换功能,使得数据处理变得更加简单和高效。

- Informatica PowerCenter

Informatica PowerCenter是一种领先的ETL工具,广泛应用于企业级数据集成项目中。它具有强大的数据集成能力、广泛的数据源支持和丰富的转换功能。Informatica PowerCenter支持多种数据源,包括关系数据库、云存储、文件系统等,能够处理大规模的数据集成任务。其丰富的数据转换功能,使得数据清洗、转换和加载变得更加灵活。

- Talend

Talend是一种开源ETL工具,以其灵活性和扩展性著称。它提供了大量的预构建组件,可以处理各种数据源和数据类型。用户可以根据需要自由组合这些组件,构建复杂的数据处理流程。由于其开源特性,Talend社区活跃,用户可以获得丰富的技术支持和资源。

- Apache Nifi

Apache Nifi是一种数据流管理工具,具有强大的实时数据处理能力。它支持多种数据源和数据格式,可以实时采集、转换和传输数据。其可视化设计界面使得用户可以直观地设计和管理数据流。Nifi提供了丰富的处理器,可以处理各种数据转换和传输需求。

- Pentaho

Pentaho是一种综合性的商业智能(BI)和数据集成工具。它提供了全面的数据集成解决方案,可以处理各种数据源和数据类型。其数据集成工具Kettle提供了丰富的转换和作业功能,使得数据处理变得更加简单和高效。

- SSIS

SSIS是Microsoft SQL Server Integration Services的简称,是Microsoft提供的一款ETL工具。它支持SQL Server和其他数据源之间的数据集成,提供了丰富的转换和组件库,可以满足各种数据处理需求。

四、ETL程序开发的流程

ETL程序开发的流程通常包括需求分析、设计、开发、测试和部署等阶段。

- 需求分析

在需求分析阶段,需要明确ETL程序的目标、数据源、目标系统以及数据处理的具体要求。这有助于为后续的设计和开发工作提供明确的指导。

- 设计

在设计阶段,需要根据需求分析的结果,设计ETL程序的架构、数据流、转换逻辑等。这包括确定数据源和目标系统的连接方式、设计数据转换的规则和流程等。

- 开发

在开发阶段,需要根据设计阶段的结果,编写ETL程序的代码。这包括编写数据提取、转换和加载的代码,以及实现数据清洗、转换和格式化的逻辑等。

- 测试

在测试阶段,需要对ETL程序进行全面的测试,包括单元测试、集成测试和系统测试等。这有助于确保ETL程序的正确性和稳定性。

- 部署

在部署阶段,需要将ETL程序部署到生产环境中,并进行相关的配置和调试工作。这包括配置数据源和目标系统的连接信息、设置ETL程序的运行参数等。

五、ETL程序开发的最佳实践

在ETL程序开发过程中,遵循最佳实践有助于提高开发效率和质量。以下是一些ETL程序开发的最佳实践:

- 模块化设计:将ETL程序划分为多个模块,每个模块负责特定的数据处理任务。这有助于降低程序的复杂度,提高代码的可读性和可维护性。

- 数据校验:在数据处理过程中,对数据进行校验和验证,确保数据的准确性和完整性。这有助于避免数据错误和异常情况的发生。

- 日志记录:在ETL程序中添加日志记录功能,记录程序的运行情况和数据处理结果。这有助于后续的问题排查和性能优化工作。

- 性能优化:对ETL程序进行性能优化,提高数据处理的速度和效率。这包括优化数据提取、转换和加载的逻辑、使用高效的算法和数据结构等。

- 安全性保障:在ETL程序中添加安全性保障措施,如数据加密、访问控制等。这有助于保护数据的机密性和完整性,防止数据泄露和非法访问。

六、结论

ETL程序开发是数据处理领域的重要一环,对于构建高效、可靠的数据流程具有重要意义。选择合适的ETL工具、遵循最佳实践、掌握开发流程和技巧是ETL程序开发的关键。希望本文能够帮助读者深入了解ETL程序开发的核心概念和流程,提高ETL程序开发的效率和质量。